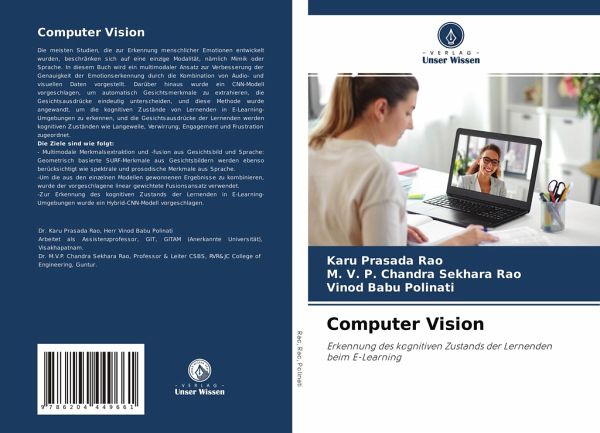

Computer Vision

Erkennung des kognitiven Zustands der Lernendenbeim E-Learning

Versandkostenfrei!

Versandfertig in 6-10 Tagen

60,90 €

inkl. MwSt.

PAYBACK Punkte

0 °P sammeln!

Die meisten Studien, die zur Erkennung menschlicher Emotionen entwickelt wurden, beschränken sich auf eine einzige Modalität, nämlich Mimik oder Sprache. In diesem Buch wird ein multimodaler Ansatz zur Verbesserung der Genauigkeit der Emotionserkennung durch die Kombination von Audio- und visuellen Daten vorgestellt. Darüber hinaus wurde ein CNN-Modell vorgeschlagen, um automatisch Gesichtsmerkmale zu extrahieren, die Gesichtsausdrücke eindeutig unterscheiden, und diese Methode wurde angewandt, um die kognitiven Zustände von Lernenden in E-Learning-Umgebungen zu erkennen, und die Gesicht...

Die meisten Studien, die zur Erkennung menschlicher Emotionen entwickelt wurden, beschränken sich auf eine einzige Modalität, nämlich Mimik oder Sprache. In diesem Buch wird ein multimodaler Ansatz zur Verbesserung der Genauigkeit der Emotionserkennung durch die Kombination von Audio- und visuellen Daten vorgestellt. Darüber hinaus wurde ein CNN-Modell vorgeschlagen, um automatisch Gesichtsmerkmale zu extrahieren, die Gesichtsausdrücke eindeutig unterscheiden, und diese Methode wurde angewandt, um die kognitiven Zustände von Lernenden in E-Learning-Umgebungen zu erkennen, und die Gesichtsausdrücke der Lernenden werden kognitiven Zuständen wie Langeweile, Verwirrung, Engagement und Frustration zugeordnet. Die Ziele sind wie folgt: - Multimodale Merkmalsextraktion und -fusion aus Gesichtsbild und Sprache: Geometrisch basierte SURF-Merkmale aus Gesichtsbildern werden ebenso berücksichtigt wie spektrale und prosodische Merkmale aus Sprache.-Um die aus den einzelnen Modellen gewonnenen Ergebnisse zu kombinieren, wurde der vorgeschlagene linear gewichtete Fusionsansatz verwendet.-Zur Erkennung des kognitiven Zustands der Lernenden in E-Learning-Umgebungen wurde ein Hybrid-CNN-Modell vorgeschlagen.