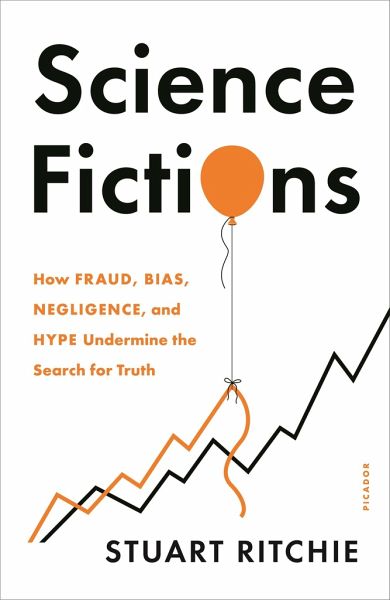

Science Fictions

Versandkostenfrei!

Versandfertig in 1-2 Wochen

21,99 €

inkl. MwSt.

Weitere Ausgaben:

PAYBACK Punkte

11 °P sammeln!

An insider's view of science reveals why many scientific results cannot be relied upon - and how the system can be reformed. Science is how we understand the world. Yet failures in peer review and mistakes in statistics have rendered a shocking number of scientific studies useless - or, worse, badly misleading. Such errors have distorted our knowledge in fields as wide-ranging as medicine, physics, nutrition, education, genetics, economics, and the search for extraterrestrial life. As Science Fictions makes clear, the current system of research funding and publication not only fails to safegua...

An insider's view of science reveals why many scientific results cannot be relied upon - and how the system can be reformed. Science is how we understand the world. Yet failures in peer review and mistakes in statistics have rendered a shocking number of scientific studies useless - or, worse, badly misleading. Such errors have distorted our knowledge in fields as wide-ranging as medicine, physics, nutrition, education, genetics, economics, and the search for extraterrestrial life. As Science Fictions makes clear, the current system of research funding and publication not only fails to safeguard us from blunders but actively encourages bad science - with sometimes deadly consequences. Stuart Ritchie's own work challenging an infamous psychology experiment helped spark what is now widely known as the "replication crisis," the realization that supposed scientific truths are often just plain wrong. Now, he reveals the very human biases, misunderstandings, and deceptions that undermine the scientific endeavor: from contamination in science labs to the secret vaults of failed studies that nobody gets to see; from outright cheating with fake data to the more common, but still ruinous, temptation to exaggerate mediocre results for a shot at scientific fame. Yet Science Fictions is far from a counsel of despair. Rather, it's a defense of the scientific method against the pressures and perverse incentives that lead scientists to bend the rules. By illustrating the many ways that scientists go wrong, Ritchie gives us the knowledge we need to spot dubious research and points the way to reforms that could make science trustworthy once again.